Kylningen kryper in mot chipet – en ny era för Thermal management

Elektronikkylning har länge varit en kamp mot dimensioner. Från värmekällan, via interface-material, värmespridare och kylflänsar, till luft eller vätska som till sist transporterar bort värmen. Länge var strategin enkel: bygg större kylare, blås mer luft eller pumpa mer vätska. Men när AI- och HPC-chip i datacenter passerar kilowatt-nivåer i effekt har den modellen nått vägs ände. Resultatet är självklart: kylningen kryper allt närmare värmekällan.

AI-träning och inferens har pressat GPU-effekter från hundratals watt till långt över en kilowatt per accelerator, och med ökande hotspot-intensitet. Det kräver högre kylkapacitet per ytenhet, inte bara mer total kylning.

Varför avståndet är det stora problemet

Moderna AI-GPU:er och acceleratorkretsar har extrem effektdensitet. Värmen uppstår i små hotspots som kan nå mycket hög temperatur på kort tid. Traditionell kylning med cold plates eller heat spreaders sitter dock utanför chipkapslingen, separerad från värmekällan av flera lager material: TIM, värmespridare, kapsling, ibland interposers eller staplade lager. Varje lager innebär termiskt motstånd – som en filt runt värmen.

Historiskt har det funkat eftersom värmeflödet per kvadratcentimeter fortfarande varit hanterbart. Men när nya chipgenerationer ökar i både total effekt och lokalt värmeflöde räcker det inte längre att kyla “ovanpå” paketet. Branschen talar allt oftare om en ny, snabbt annalkande Thermal Wall där kylningen, liksom för 20 år sedan, blir den verkliga begränsningen för vidare prestandaskalning.

Direct-die och direct-to-chip: vägen från luft till vätska

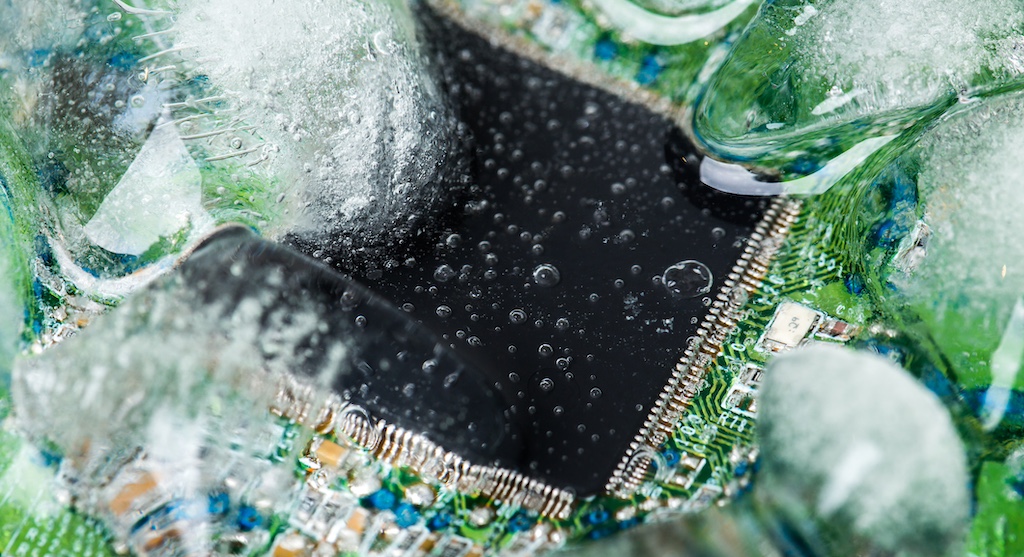

Det första stora skiftet var övergången från luftkylning till vätska i datacenter. Direct-to-chip-kylning innebär att en cold plate sätts i direkt kontakt med CPU/GPU-kapslingen och att vätska cirkulerar genom finstrukturerade kanaler i plattan. I praktiken tar man bort luftsteget helt och kortar värmetransporten.

Utvecklingen går också mot direct-die, där plattan inte bara ligger mot kapslingen utan mot själva kislet (eller en mycket tunn IHS), för att kapa ytterligare länkar i värmetransportkedjan. För högeffekt-GPU:er blir detta oundvikligt. Nya generationer använder därför mikrokanaler, jet-impingement och 3D-geometrier för att rikta kylningen exakt dit hotspots finns.

Ett exempel är Frore Systems nya LiquidJet-kylare, med 3D-formade “jet-channel” mikrostrukturer i metall. Målet är att hantera framtida AI-GPU:er på flera kilowatt och värmeflöden på hundratals watt per kvadratcentimeter – något som konventionella plattor har svårt att klara.

När kylningen flyttar in i silikonen

Nästa steg är ännu mer radikalt: kylningen går in i chipet. Under hösten 2025 har Microsoft demonstrerat ett in-chip-mikrofluidiksystem där mikroskopiska kanaler etsas in i baksidan av kiselchipet och kylvätska förs direkt mot de varmaste regionerna. I labbtester rapporteras upp till tre gånger bättre värmeavledning än dagens lösningar och kraftigt sänkta temperaturtoppar i GPU-kisel.

Det här är inte bara en smart kylare – det är ett nytt sätt att tänka chipdesign. Med mikrofluidik kan man minska den totala termiska resistansen dramatiskt, kyla lokala hotspots mer precist, och hålla chipet stabilare under spikiga belastningar, vilket möjliggör högre klockfrekvens och/eller tätare stapling. Microsofts upplägg har dessutom AI-optimerade kanalstrukturer inspirerade av naturens flödesnät (t.ex. bladnerver), vilket visar hur kylningen – så som det skall vara – blir en del av systemdesignen snarare än en efterhandslösning.

Parallellt skall startupen Corintis – som samarbetat med Microsoft – ha anskaffat kapital för att skala upp samma teknik kommersiellt, vilket signalerar att mikrofluidik kan vara på väg från prototyp till industriell verklighet.

Vad driver trenden?

AI och effektdensitet

AI-träning och inferens har pressat GPU-effekter från hundratals watt till långt över en kilowatt per accelerator, och med ökande hotspot-intensitet. Det kräver högre kylkapacitet per ytenhet, inte bara mer total kylning.

3D-stackade chip och nya arkitekturer

Framtidens chip bygger mer på chiplets och 3D-stackning för lägre latens och högre bandbredd. Men staplade lager gör värmetransporten längre om kylningen inte följer med in. In-die mikrofluidik är en av få tekniker som realistiskt kan kyla de inre lagren i 3D-design.

Effektivitet och hållbarhet

När kylningen sker nära källan behöver vätskan inte vara lika kall, vilket sänker energin för kylmaskiner och pumpar och förbättrar PUE. För hyperscalers är energikostnaden numera lika strategisk som chipkostnaden.

Utmaningarna som återstår

Att flytta kylningen närmare värmekällan löser mycket – men skapar nya problem:

Tillverkningskomplexitet: att etsa mikrokanaler i kisel kräver nya processteg och extrem precision.

Kapsling och läckrisk: vätska nära eller i chip kräver heltäckande, robust inkapsling. Detta är förvisso inte ett nytt problem, då vätskekylning på chip-nivå funnits ett tag.

Systemintegration: när kylningen går in i chipet måste flödesvägar, pumpar, förgreningar och servicebarhet designas in i servern på ett annat sätt än tidigare.

Det är alltså inte bara en komponentinnovation, utan ett steg mot co-design av chip, kapsling och datacenter.

Vart är vi på väg?

Thermal Management går samma väg som all övrig utveckling inom elektronik: miniatyrisering, integration och sammanpackning. Direct-die-plattor blir standard i högprestandasystem, kylare får mikro- och jet-strukturer för hotspots, och microfluidik i kisel kommer gradvis in i de mest värmekritiska AI- och HPC-plattformarna.

Den verkliga poängen är att kylning inte längre är en eftertanke. När den flyttas in mot värmekällan blir den en förutsättning för nästa generations chiparkitektur – och minst lika viktig som konkurrensfaktor som processorprestandan.

Missa inte att anmäla dig till Cool Sweden Workshops 2026 – evenemanget för dig som arbetar med Thermal Management och kylning av elektronik.